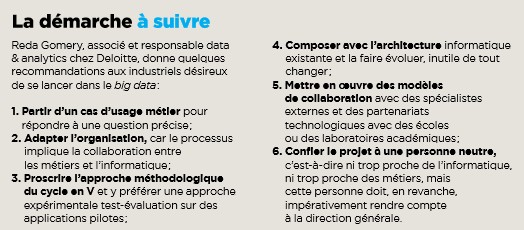

Il y a un buzz phénoménal autour du big data et, cette fois, il est amplement justifié. « Les données sont le nouvel or noir », affirme-t-on ici et là. Ce n’est pas exagéré. Les grandes entreprises industrielles françaises l’ont compris et ne sont pas à la traîne en la matière. « La plupart d’entre elles ont conscience de l’importance du sujet », constate Reda Gomery, associé et responsable data & analytics chez Deloitte. Iltempère toutefois : « Si toutes ont saisi l’importance de la technologie et commencent à s’y lancer, seule une partie d’entre elles ont vraiment perçu qu’audelà de la technologie, l’exploitation des données massives était un puissant vecteur de la transformation numérique, et agissent de façon à profiter pleinement de ce potentiel. » L’industrie, il faut le dire, est une adepte de longue date de l’analyse de données. Alors, que s’est-il passé pour qu’elle juge utile de se lancer à corps perdu dans le big data ? Un petit rien qui change tout. Hier, les données utilisables étaient rares et leur exploitation onéreuse avec un coût croissant exponentiellement avec le volume. Aujourd’hui, les données exploitables sont en nombre illimité, leur traitement en volume beaucoup plus facile techniquement et à un coût que le volume n’affecte quasiment plus. Pour résumer abruptement : une denrée rare et chère est devenue abondante et « gratuite », ou du moins nettement moins coûteuse. De quoi changer radicalement la donne. Hier on hésitait à multiplier d’onéreuses analyses. Aujourd’hui, no limit !

Il y a un buzz phénoménal autour du big data et, cette fois, il est amplement justifié. « Les données sont le nouvel or noir », affirme-t-on ici et là. Ce n’est pas exagéré. Les grandes entreprises industrielles françaises l’ont compris et ne sont pas à la traîne en la matière. « La plupart d’entre elles ont conscience de l’importance du sujet », constate Reda Gomery, associé et responsable data & analytics chez Deloitte. Iltempère toutefois : « Si toutes ont saisi l’importance de la technologie et commencent à s’y lancer, seule une partie d’entre elles ont vraiment perçu qu’audelà de la technologie, l’exploitation des données massives était un puissant vecteur de la transformation numérique, et agissent de façon à profiter pleinement de ce potentiel. » L’industrie, il faut le dire, est une adepte de longue date de l’analyse de données. Alors, que s’est-il passé pour qu’elle juge utile de se lancer à corps perdu dans le big data ? Un petit rien qui change tout. Hier, les données utilisables étaient rares et leur exploitation onéreuse avec un coût croissant exponentiellement avec le volume. Aujourd’hui, les données exploitables sont en nombre illimité, leur traitement en volume beaucoup plus facile techniquement et à un coût que le volume n’affecte quasiment plus. Pour résumer abruptement : une denrée rare et chère est devenue abondante et « gratuite », ou du moins nettement moins coûteuse. De quoi changer radicalement la donne. Hier on hésitait à multiplier d’onéreuses analyses. Aujourd’hui, no limit !

Numérisation généralisée des entreprises

Plusieurs facteurs se sont combinés pour favoriser ce changement radical. Primo, l’augmentation de puissance des ordinateurs qui accélère notablement le traitement. Secundo, la numérisation généralisée des entreprises. Plus important encore, l’arrivée de nouvelles technologies (Hadoop, Map Reduce,

NoSQL,…) qui traitent désormais des volumes phénoménaux d’information en temps réel et sans sourciller. Mieux encore. L’analyse de données ne pouvait s’effectuer que sur des données structurées. Ces outils autorisent désormais le traitement de données non structurées de n’importe quel type, autrement dit de l’immense majorité des données disponibles, dont on ne savait, jusque-là, que faire. Et la corne d’abondance n’est pas près de se tarir, avec notamment le véritable déluge de données que promettent les objets connectés.

Les techniques de traitement de données massives ont une autre grande

« Où en êtes-vous avec votre projet big data, M. Hoskins ? »

Pendant ce temps, les industriels, extrêmement pragmatiques, se sont attelés à l’exploration de cet univers, et à la prise en main de la technologie. Ils commencent par des applications pilotes très concrètes, correspondant à une problématique métier bien identifiée, comme le recommande d’ailleurs Deloitte (lire l’encadré). On n’en est évidemment qu’au tout début mais déjà des cas d’usages variés ont vu le jour dans toutes les industries. Ils ne sont d’ailleurs pas toujours « big data » au sens de la définition stricte du concept qui implique notamment le traitement de très gros volumes, et celui de données non structurées. Parfois, l’application développée ne porte que sur un volume (relativement) restreint de données. Souvent, on se contente de travailler sur les seules données structurées. N’empêche. Cela constitue déjà une véritable incursion dans le domaine. Et la récente annonce du groupe Safran de la création de Safran Analytics, une nouvelle entité dédiée au big data montre bien à quel point le sujet est pris au sérieux. L’entité prévoit en 2015 l’embauche d’une quarantaine de salariés qui travailleront pour l’ensemble du groupe sous la direction de Ghislaine Doukhan, directement rattachée à Marc Ventre, directeur général délégué en charge des opérations. Sur quoi se sont lancés les industriels ? Renault collecte, par exemple, sur ses différents sites Internet, des données sur les préférences de ses clients potentiels. Ce projet, en phase préliminaire, a pour objet de vérifier s’il est possible, à partir de l’analyse de ces données de découvrir quelles sont leurs préférences. Objectif : anticiper les types de modèles (couleur, options, etc.) à lancer en priorité en fabrication. « D’ici à quelques années, cela pourrait bouleverser les méthodes de travail de nos chaînes de production », dit Patrick Hoffstetter, chief digital officer de Renault. PSA Peugeot-Citroën, de son côté, entre autres applications, récupère les données des réseaux sociaux pour tenter de découvrir ce que ses clients potentiels pensent de ses voitures afin de mieux cibler ses campagnes de marketing. Il a déjà mené un premier test autour de la Citroën Cactus. Le marketing est, en effet, l’un des champs privilégiés de la technologie et les industries créatrices de produits de grande consommation, comme L’Oréal qui a nommé, en mars dernier, Lubomira Rochet au poste de chief digital officer voué à la transformation numérique, s’y intéressent très sérieusement.

Pierre Naggar, directeur EMEA de Turn, agence de marketing, cite le cas d’un client américain, Kraft Foods, qui a utilisé cette technique pour relancer un produit en déclin. En s’appuyant sur des données riches, le groupe a préparé différents messages concernant cette gamme et les a promus vers ses clients en fonction de leur comportement en ligne. Résultat : « Un taux d’appréciation de la marque et des intentions d’achat en hausse de 11 % », assorti d’un retour sur les dépenses publicitaires « deux ou trois fois supérieur à celui des campagnes précédentes. »

La maintenance préventive, voire prédictive, est bien sûr l’autre appli de choix. Elle se pratiquait déjà chez Snecma, avant même qu’il ne soit question de big data. Les cas se multiplient désormais. SAP, par exemple, indique que le fabricant de tracteurs John Deere s’y est mis et l’éditeur allemand propose même une application spécifique de maintenance prédictive autour de son outil SAP Hana. On découvre aussi des applications comme l’optimisation de la gestion des stocks. La start-up française Lokad s’en est fait une spécialité. Elle a commencé dans le domaine du retail et a étendu ses prestations au secteur de l’industrie aéronautique. En moulinant des brassées de données issues de multiples sources, elle fournit à ses clients (une demi-douzaine de compagnies aériennes) des informations pour qu’ils disposent des bonnes pièces détachées au bon endroit au bon moment, le tout pour le coût minimal. C’est à la fois un problème très complexe et crucial pour les compagnies. Elles doivent à tout prix éviter d’immobiliser un avion au sol, faute de pièce de rechange, et essaient simultanément de minimiser les stocks très coûteux de pièces.

| Rien de magique |

|

« Le big data n’a rien de magique. C’est une science fondée sur les mathématiques appliquées et l’informatique avancée », précise Bruno Teboul. Cette mise en garde du directeur scientifique, R&D et Innovation de Keyrus, entreprise de services numériques, n’est faite que pour mieux marquer le véritable changement de paradigme qui s’est produit avec le traitement des données massives. « Jusqu’à présent, les statisticiens mettaient en œuvre des outils mathématiques propres à répondre à une question précise à partir d’hypothèses fondées sur des données structurées et historicisées. Avec l’arrivée de masses de données non structurées, telles que celles qui peuvent être acquises sur les réseaux sociaux en particulier, il n’est plus possible de procéder de la sorte. Désormais, on travaille à l’envers : on part des données disponibles – soigneusement récoltées, nettoyées et normalisées – et on essaie d’élaborer des hypothèses. C’est la méthode dite abductive qui fonctionne par le recours à l’inférence de la meilleure explication à partir des données brutes. Et c’est le travail du data scientist, aidé par des techniques comme le machine learning, de faire émerger du sens à partir des données en appliquant les algorithmes les mieux adaptés à chaque cas. » Ce changement radical de méthode – qui ne périme pas les outils classiques – s’applique aux données non structurées, comme celles structurées à traiter. « Ce qui permet parfois de faire sortir des pépites inattendues d’un immense magma de données et de trouver des réponses à des questions qu’on ne se posait pas nécessairement. » Puissant, mais pas magique ! |

Le potentiel des objets connectés

Lancée par Michelin Solutions, Effifuel permet aux flottes de poids lourds de réduire leur consommation de carburant, grâce à l’analyse d’un ensemble de données issues des véhicules (opérations de contrôles et maintenance des pneus, charge transportée, parcours, vitesse, dénivelés…) et mises en perspective avec l’aide de CGI.

Reste que, pour l’industrie, l’application qui recèle probablement le plus de potentiel est liée aux objets connectés. Dès lors qu’un produit est capable de fournir en continu des masses d’information sur son comportement – et celui de ses utilisateurs –, un champ immense s’ouvre à l’imagination. La maintenance prédictive déjà citée est évidemment la première exploitation de ce monitoring permanent – et en temps réel – des produits. Mais il en apparaît déjà d’autres. Chez Snecma comme chez PSA, on se montre très intéressé par les enseignements tirés des données réelles du comportement des produits en fonctionnement. Quel formidable banc d’essais, pour en améliorer la conception. Michelin Solutions, de son côté, a bâti avec CGI une application, Effifuel, qui, à partir de toutes les informations reçues depuis une flotte de camions, permet d’en réduire significativement la consommation. L’entreprise est si sûre de son coup qu’elle ne se rétribue que sur les gains réellement obtenus.

On l’a dit, la véritable puissance du big data tient au changement de paradigme qu’il introduit. Pour faire simple et court : on ne se contente plus de valider des hypothèses comme avec la statistique classique, on découvre, en moulinant des océans de données, des corrélations permettant d’échafauder des hypothèses nouvelles. Exemple typique, la façon dont Snecma envisage d’exploiter les données de ses bancs d’essais moteurs pour découvrir des informations que les connaissances actuelles ne peuvent pas anticiper… Autre exemple, celui fourni par le Français Quinten, spécialisé dans la valorisation des données. Son client (qui ne tient pas à dévoiler son identité) faisait face à un sérieux problème : en quelques mois, deux importants dysfonctionnements étaient apparus sur ses machines tournantes. Impossible d’en découvrir la cause. C’est en analysant, à partir des données issues de six mois de fonctionnement (au rythme de dizaines de milliers de points de mesure toutes les dix minutes) que le problème a été identifié. Il est apparu dans les deux cas qu’une certaine configuration très spéciale de température et de pression s’était produite juste avant la panne – et dans ces deux cas seulement. Si la cause exacte n’a pas été identifiée, l’entreprise dispose pour le moins d’informations lui permettant d’éviter que la panne ne se reproduise. Quinten, par ailleurs, travaille beaucoup avec l’industrie pharmaceutique, notamment dans le cadre des analyses cliniques. Une industrie pour laquelle l’apport de traitement de données massives peut être colossal.

La nécessité de nouvelles compétences

Cela dit, attention ! Avec ces exemples, il est tentant de déduire – et beaucoup ne font rien pour vous en dissuader – qu’il suffit de réunir des volumes colossaux de données, de secouer le tout avec un peu d’Hadoop, pour récolter des trésors. Autrement dit, le big data aiderait à faire de formidables découvertes à partir d’un magma totalement informe de données brutes. Erreur fatale ! Le big data n’est pas « magique », comme insiste Bruno Teboul. C’est même une technologie difficile à maîtriser, voire très difficile. Au point que pour obtenir des résultats satisfaisants sont apparus les data scientists, espèce encore rare et fort convoitée. Pourquoi recourir à un data scientist ? Parce que pour profiter des bienfaits du big data, il faut commencer par avoir une idée précise de ce que l’on cherche. Il faut ensuite collecter des quantités phénoménales de données, mais pas n’importe lesquelles : celles qui sont le plus susceptibles d’être utiles dans le contexte donné. Puis, il faut les « nettoyer », les organiser, les normaliser… Il faut enfin leur appliquer des algorithmes pertinents, c’est-à-dire à la fois adaptés aux caractéristiques des données à traiter, et aux résultats envisagés.

Pour ce faire, le data scientist est épaulé par des outils tels que le machine learning. Par auto-apprentissage, cette technique sert à déterminer le type d’algorithmes à mettre en œuvre pour extraire du sens de la masse de données et d’automatiser le process. Mais, en fin de compte, c’est toujours l’opérateur humain qui reste l’acteur principal du travail. Pour ce faire, il doit non seulement être un expert pointu en mathématiques et informatique avancée, mais aussi posséder une bonne connaissance du métier de l’entreprise pour laquelle il travaille, c’est-à-dire être au fait de ses besoins et de ses enjeux. C’est cet ensemble de qualités – et pas le seul machine learning, aussi évolué soit-il – qui permet de faire les choix les plus judicieux à tous les stades du processus.

Actuellement, le big data est sous le feu des projecteurs. Il a atteint le « peak of inflated expectations » de la fameuse courbe du Gartner Group qui décrit le cycle de « hype », de toute nouvelle technologie. La surexcitation autour du sujet est à son apogée. Chacun sait toutefois qu’après ce sommet vient inévitablement l’étape suivante : le « gouffre de la désillusion ». Le moment où les promesses non tenues et la complexité de la mise en œuvre concrète suscitent doute et déception. Mais on peut prédire sans trop de risque que le potentiel de la technologie est tel qu’il ne se passera guère de temps avant que le big data ne fasse la preuve de sa formidable capacité de transformation et d’innovation. Le temps que les utilisateurs, dans l’industrie comme ailleurs, découvrent ses plus fructueux domaines d’application et que des « killer apps », encore inimaginables, voient le jour. C’est bien parti, même si les grands groupes sont souvent handicapés par la lourdeur des processus de décision. Quoi qu’il en soit, de fantastiques surprises nous attendent.

* Lire le rapport : « Industrial Internet : Pushing the Boundaries of Minds and Machines », de Peter C. Evans et Marco Annunziata

A découvrir aussi – sur le même sujet – dans le N°11 d’Alliancy, le mag les articles suivants :

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders Alliancy Elevate

Alliancy Elevate International

International Nominations

Nominations Politique publique

Politique publique

Enquête spéciale : le secteur public sait-il séduire les développeurs ?

Enquête spéciale : le secteur public sait-il séduire les développeurs ?  [Série] Collectivités territoriales : Enfin l’accélération numérique ?

[Série] Collectivités territoriales : Enfin l’accélération numérique ?