Julien Niedergang, Ingénieur Système chez SUSE

Si l’essor du Software-Defined Storage n’est pas vraiment une bonne nouvelle pour les fournisseurs traditionnels, les équipes informatiques au contraire y ont tout à gagner, que ce soit en matière d’évolutivité illimitée, de baisse des coûts ou d’administration des solutions non-propriétaires. Le concept open source signe l’arrêt de mort des monopoles détenus par les fournisseurs (le « vendor lock-in ») et l’avènement d’une réelle portabilité sur le cloud.

En ce qui concerne le stockage, l’avenir passe par les environnements open source et le cloud. Pourquoi ? Parce que les équipes informatiques attendent deux choses de la virtualisation : Une réduction des coûts et de leur dépendance vis-à-vis des fournisseurs.

Il y a une dizaine d’années, les datacenters étaient très différents de ce qu’ils sont aujourd’hui. Chaque application disposait de ses propres serveurs et outils de stockage qui fonctionnaient dans une série d’« îlots technologiques » bénéficiant chacun d’une puissance de traitement suffisante pour réagir sans problème en cas de hausse soudaine de la demande. Inévitablement, le fait de garantir un fonctionnement fluide et confortable en cas de pic impliquait un « surprovisionnement » : les serveurs étaient en fait dimensionnés pour délivrer toute l’année une capacité de traitement a priori taillée pour les pics saisonniers comme les fêtes de Noël. Pendant des années, les DSI ont empilé les applications, ce qui a nécessité l’ajout successif de serveurs rack par rack avec un encombrement au sol de plus en plus réduit — et une facture d’électricité en hausse vertigineuse en raison des coûts d’énergie et de refroidissement. La démesure était telle que certaines entreprises utilisaient le datacenter pour chauffer leurs locaux, tandis que d’autres l’installaient à flanc de montagne pour réduire leurs dépenses de ventilation !

À chaque nouveau serveur, la puissance de traitement en veille augmentait, le potentiel « en jachère » finissant par devenir réellement énorme. Imaginez que l’on construise un barrage sur un fleuve impétueux où le moindre filet d’eau s’écoule sur le front de l’édifice tandis que le potentiel d’énergie s’accumule en amont dans le bassin de retenue. La virtualisation a ouvert les vannes, libérant une exceptionnelle capacité de traitement qui peut être utilisée par de nouvelles applications avec une puissance accessible sur demande en appuyant sur un interrupteur, un provisionnement rapide, la possibilité de faire « plus avec moins », des factures d’électricité en baisse, des datacenters moins encombrants et la séparation effective entre les fournisseurs de logiciels et les équipements matériels. Exit les onéreux serveurs propriétaires, voici l’heure des produits standard dont le prix est le seul critère différenciateur. Dans ce monde où tous les serveurs se ressemblent, le meilleur est simplement le moins cher. Cerise sur le gâteau, le nombre de nouveaux serveurs physiques nécessaires est en chute libre. Face à ce potentiel non exploité, pourquoi en rajouter ?

La virtualisation est aujourd’hui une évidence ; son utilisation est si simple, si limpide, que son adoption a été immédiate et quasi-universelle. Pour les équipes informatiques, la virtualisation se traduit par une meilleure utilisation des ressources informatiques, une réduction de la dépendance vis-à-vis des fabricants et surtout, par des gains de coût. Accolez le terme « virtuel » à toute technologie, et le DSI aura la conviction — explications du fournisseur à l’appui — qu’il pourra faire plus avec moins, et à moindre coût. Des années d’expérience et la mise en oeuvre de bonnes pratiques ont amené les équipes informatiques à faire rimer virtualisation avec réduction des coûts. Le stockage ne fait pas exception. Un fournisseur qui évoque la virtualisation du stockage en demandant une augmentation des investissements verra sa conversation avec le client s’écourter rapidement.

La virtualisation du stockage remet en cause les modèles traditionnels des fournisseurs

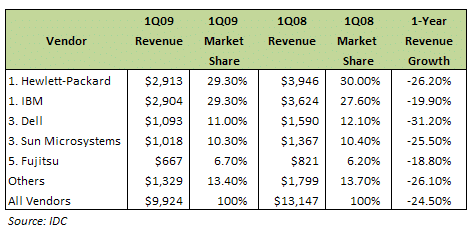

Si les DSI ont récolté les avantages d’une meilleure utilisation des ressources ainsi qu’une réduction de leurs dépenses, c’est au détriment des fournisseurs dont les ventes fondent comme neige au soleil. Tandis que décollait l’adoption de la virtualisation des serveurs, les ventes de serveurs subissaient une forte chute, passant d’un gain trimestriel régulier, tant en volume qu’en valeur, à une baisse catastrophique. En 2009, alors que la récession battait son plein (qui en soi accélère la virtualisation en raison des baisses de coûts qu’elle induit), les analystes du cabinet IDC signalaient les premières baisses de ventes des serveurs. Tous les grands noms du marché — HP, IBM, Dell, Sun Microsystems (maintenant Oracle) et Fujitsu — ont accusé un énorme recul de leurs ventes — entre 18,8 et 31,2 % en une année. Le choc a été moins fort pour dans les segments CISC et RISC haute puissance où il est plus difficile de changer de fournisseur (c’est le cas, par exemple, des applications Oracle où le coût des licences est lié au nombre de processeurs utilisés ou à un matériel spécifique) ; en revanche, l’impact a été particulièrement sensible sur le marché des produits x86 d’entrée de gamme.

Les changements n’ont pas tardé. IBM a quitté le marché de la microinformatique, vendant ses activités à Lenovo qui, avec un outil de fabrication moins onéreux, des salaires moins élevés et des taux de change contrôlés, dispose de meilleurs atouts pour s’en sortir. HP a vu les CEO se succéder à la tête de ses activités, avec autant de réinventions à la clé, tandis que Dell redevenait une entreprise privée. Cette mutation ne va pas tarder à se produire sur le marché du stockage.

Lorsque les plus grands fournisseurs souffrent autant, il faut s’attendre à des changements et à l’apparition de technologies de rupture. Les acheteurs de produits informatiques cessent de regarder les marques de la même manière. Après l’ère des partenaires de confiance, des feuilles de route blindées sur le long terme et à faible risque, il semble que les acteurs historiques du marché soient remis en cause par de nouveaux-venus, leurs approches et leurs technologies novatrices. Le célèbre slogan des années 70, « personne n’a jamais a été licencié pour avoir acheté des produits IBM » est caduque quand IBM ferme boutique et cède son activité Serveurs d’entreprise. Les acheteurs de produits informatiques s’attendent à une évolution similaire dans le domaine du stockage, et ils ont raison !

Dans cet environnement, le statu quo qui règne parmi les fournisseurs de solutions de stockage ne peut durer éternellement. Les grands noms s’observent en chiens de faïence, attendant que l’un ou l’autre prenne une décision dans ce qui ressemble à un poker menteur aux mises astronomiques. Le modèle métier propriétaire est une quinte aux couleurs délavées, et tous savent que tôt ou tard, quelqu’un dénoncera leur bluff quant aux prix pratiqués et aux logiciels propriétaires. En 2016, un nouveau venu, voire l’un des participants existants, reprendra la main, ou comme l’annonce Joe Skorupa, analyste et vice président du cabinet Gartner, « donnera le premier coup de semonce ».

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders Alliancy Elevate

Alliancy Elevate International

International Nominations

Nominations Politique publique

Politique publique