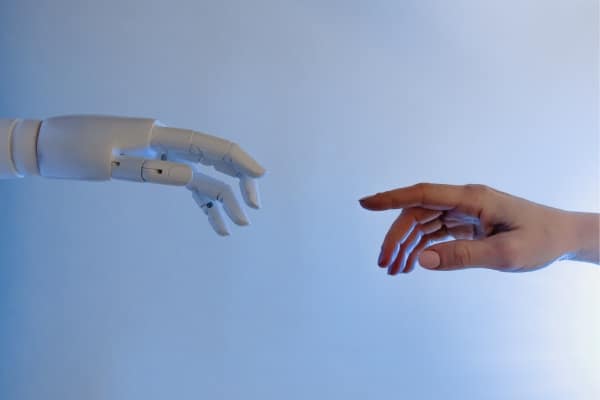

Face aux actualités qui se multiplient sur les IA génératives comme ChatGPT, Michel Juvin consacre sa nouvelle chronique à un état des lieux des risques et promesses que l’intelligence artificielle a amené dans l’Histoire. En s’interrogeant : quels sont les écueils à contourner dans cette nouvelle évolution de l’Homme ?

Avec l’intelligence artificielle dont les cas d’usage se multiplient, sommes-nous à l’aube d’une nouvelle évolution de l’Homme ? Sera-t-elle positive ou risque-t-elle, comme certains le pensent, d’être négative ?

L’objet de cet article est de présenter de manière synthétique l’évolution de l’intelligence artificielle depuis la conception des moteurs d’inférences vers les usages de l’IA générative d’aujourd’hui ; afin d’aborder justement, les dimensions anxiogène, philosophique et politique, qui permettent de proposer des pistes de réponse aux deux questions précédentes.

A lire aussi : [Edito] ChatGPT, Bard, Ernie… et les autres

Commençons par un peu d’histoire…

Ada Lovelace est la première femme (1843) à avoir imaginé un programme informatique alors qu’elle était dans l’équipe de chercheurs de Charles Babbage que la machine analytique la passionnait. Traduisant un article, initialement écrit en français, de Fédérico Luigi Menebrea, elle poursuit ses réflexions en ajoutant des notes dont l’une est une description d’une machine pour résoudre les nombres de Bernoulli ; on lui reconnaît donc avoir imaginé le premier programme informatique. Ce premier programme modulable ne vit le jour (physiquement) qu’au début du 20e siècle avec l’utilisation des premières cartes perforées dites cartes Jacquard conçues initialement pour programmer les machines à tisser.

La deuxième machine assemblant des étapes d’un programme fut créée par Alan Turing pendant la deuxième guerre mondiale afin de décoder les machines Enigma utilisées par la marine allemande, il créa aussi le premier programme de jeu d’échecs.

Les bases de l’intelligence artificielle naissent alors chez les anglo-saxons avec l’enchaînement de fonctions mathématiques ; on traduit en France le terme « Artificial Intelligence » en « Intelligence Artificielle ». Mais revenons à la définition de l’intelligence pour comprendre la différence.

Mais au fait, qu’est-ce que l’intelligence ?

Nous associons souvent la notion de capacité de raisonnement et de réflexion autour de la définition de l’intelligence dans l’objectif de solutionner des problèmes. Howard Gardner apporte en 1983 une définition de l’intelligence suivant 9 domaines que l’on exerce régulièrement dans la vie courante. L’intelligence interpersonnelle, spatiale, naturaliste, musicale, logico-mathématique, existentielle, corporelle, verbale et intrapersonnelle ; autant de domaines que l’école, la formation et la vie nous permet d’apprendre et qui nous permet de réagir intelligemment.

Beaucoup de ces domaines nécessitent d’avoir mémorisé des informations et savoir en tirer des enseignements, ce que le cerveau fait naturellement. Nous sommes tous plus ou moins brillants dans un ou plusieurs de ces domaines.

On évalue souvent l’intelligence par le Quotient Intellectuel (QI), qui est une mesure psychométrique évaluée dans le cadre d’un questionnaire variant en fonction de l’âge. Certains chercheurs ont aussi identifié des « composants » du QI, comme le facteur G – « G » pour intelligence générale – qui mesure les aptitudes cognitives, ou encore le quotient émotionnel, etc. Ces tests ont valeur de référence et peuvent s’appliquer aux humains ainsi qu’à ces nouvelles intelligences artificielles.

Peut-on vraiment demander à une machine d’être intelligente … artificiellement au moins ?

Les recherches ont été nombreuses pour développer des machines qui reproduisaient les mouvements physiques de l’Homme (comme les machines à tisser de la fin du 19e siècle) ; s’en est suivi la révolution industrielle du début du 20e. Vers 1950, les réflexions autour d’une forme d’intelligence ou l’enchaînement d’étapes ont vu le jour avec la modélisation en tant que telle de l’intelligence artificielle. Les jeux d’échecs furent une première forme pratique de l’IA, puis d’autres jeux de sociétés ont montré la capacité des machines à jouer et être meilleure que l’Homme.

On s’aperçoit que la connaissance (base d’informations) est nécessaire pour donner la capacité à une machine de faire le bon choix. A titre d’exemple, le jeu d’échec électronique de Deep-Blue a enregistré toutes les étapes des matchs joués dans le monde et, connaissant les règles de déplacements des pièces de l’échiquier, il ne lui restera alors qu’à choisir la succession d’étapes qui le mèneront à la victoire contre G.Kasparov en 1996.

Dans le détail, l’intelligence artificielle repose sur une base de faits et un moteur d’inférence. La base de faits dans l’exemple du jeu d’échecs est la somme de toutes les parties jouées et, le moteur d’inférence est un ensemble de conditionnels de la forme : si A et B alors C. C’est une succession de règles plus ou moins complexes comportant des conditionnels, des inclusions et des exclusions. Enfin, une interface graphique reconnaît l’échiquier sous forme de faits et propose facilement la solution gagnante en s’appuyant sur les faits enregistrés animés par le moteur d’inférence.

On comprend que cette intelligence artificielle n’est qu’une succession d’étapes programmées en fonction d’un contexte. La capacité d’adaptation de cette « intelligence » n’est liée qu’au nombre de cas de la base de faits. Il n’y a rien d’innovant dans cette étape du jeu. On peut donc conclure qu’un jeu d’échec électronique n’est pas intelligent au sens où on l’entend ; il n’est qu’artificiellement intelligent.

Les chercheurs en IA ont fortement progressé sur plusieurs axes et développé des moteurs d’inférence de niveau supérieur ; le niveau 0+ est un moteur d’inférence auquel on ajoute la notion des « non-faits ». Il utilise la base de règles en sens inverse pour obtenir de nouveaux faits. Dans l’exemple précédent, si la base de faits contient C alors on a A et B. Ces premières version des moteurs d’inférences recopiaient le fonctionnement humain.

Le moteur de niveau 1 est capable en théorie d’ajouter de nouvelles règles ce qui pourrait s’apparenter à une forme d’apprentissage de la connaissance. Cette profonde évolution des moteurs d’inférences est caractérisée par le Machine Learning qui apprend par analyse statistique en créant un modèle dont l’erreur est statistiquement la plus faible.

Mais on constate que le plus grand développement de l’intelligence artificielle a été réalisé grâce à l’acquisition de données à grande échelle ce qui a permis d’augmenter considérablement les bases de faits. D’une part, les performances des solutions technologiques ces dernières années ont permis l’acquisition d’images et de reconnaissance de caractères dans les textes (absorption de bibliothèques entières de livres et lecture en continue de l’internet), d’autre part, les moteurs d’inférence ont acquis des capacités d’ajout de règles comme les réseaux neuronaux et le Deep Learning qui s’adaptent tels les neurones de notre cerveau.

Que la machine apprenne d’elle-même…

La deuxième révolution de l’IA a été lors de l’inversion d’approche comme le mentionne Stéphane Mallard. Au lieu d’une informatique traditionnelle qui décrit le processus et demande à la machine de réaliser les opérations (sans réfléchir), on va demander à la machine d’établir des règles pour proposer des solutions.

En fait, au lieu de tenter de découvrir le fonctionnement du cerveau et le reproduire dans une machine, donnons l’environnement pour que la machine apprenne d’elle-même.

C’est ainsi qu’AlphaGo a battu Lee Se-Dol en 2016 au jeu de Go ; jeu qui nécessite de connaître beaucoup de règles et une grande capacité de prédiction du jeu de l’adversaire. Contrairement au jeu d’échecs, on voit que les règles du moteur d’inférence complète l’impossibilité de mémoriser toutes les positions.

Un très bon exemple de ces progrès sont les agents conversationnels tel ChatGPT d’OpenAI ou Bard de Google et leurs IA générative de contenus, qui bénéficient d’une grande quantité de faits et d’un moteur d’inférence autorisant une bonne solution face à un problème aujourd’hui spécifique et demain sans doute généraliste. La mise en forme de la réponse sous une forme conversationnelle est aussi intéressante mais n’est pas le fruit d’une intelligence artificielle comme le rappelle Yann Le Cun.

Cependant, au-delà de constater qu’une machine entraînée comme Alphago de Google DeepMind est capable de battre le meilleur joueur du moment sur un domaine très précis tel le jeu de Go, on constate qu’avec les IA génératives, il est fort probable que ces dernières obtiennent des résultats au test de QI plus fort que bon nombre d’Humains !

Si ces IA génératives sont effectivement capables d’apprendre au contact des informations échangées lors des questions soumises, il est également probable qu’une course soit lancée entre ces IA génératives (par Google, OpenAI, META…) pour devenir la plus « intelligente » !

Peut-on pervertir le raisonnement d’une intelligence artificielle ?

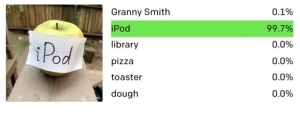

Dans les versions encore en apprentissage des récents agents conversationnels, il est toutefois facile de mettre en évidence des erreurs qui sont dues aux limites du raisonnement des moteurs d’IA ; lesquels sont entraînés pour la réponse la plus probable.

Les opérations simples pour notre cerveau ne sont pas si simples à faire pour ces machines. La limite est aussi atteinte rapidement dans le jeu de poker par exemple. Par exemple, une machine peut apprendre rapidement le raisonnement du cerveau humain et le mettre en échec. Mais l’Humain a facilement compris qu’en jouant de manière incohérente, la machine ajouterait une règle dans le moteur d’inférence qui viendrait détruire l’apprentissage acquis au cours des premières parties de jeu.

C’était sans compter sur la capacité « d’apprendre » des intelligences artificielles, et plus tard, en 2017, Libratus pulvérisait les meilleurs joueurs de poker.

Il reste cependant encore des progrès à faire pour les IA. Des cas montrent la limite de la machine par rapport à l’intelligence humaine. Par exemple, lorsqu’il s’agit de comprendre au-delà des mots : comme l’interprétation de la phrase « John is too stubborn to talk to » qui se traduit par « John est trop têtu pour être raisonnable » et que la machine traduira en John est trop têtu pour parler à quelqu’un, ainsi que le souligne un intéressant article de Philosophie Magazine. La différence de sens est importante !

De même, la machine ne fait pas la différence entre le possible que le cerveau humain sait estimer et l’impossible. Ainsi, l’Humain estime ce qui doit être et la machine propose ce qui pourrait être. On a l’impression que le nombre de cas nécessaire au cerveau humain pour comprendre et savoir est beaucoup plus faible que celui nécessaire à la machine. Mais connait-on vraiment le processus d’apprentissage du cerveau ? Depuis la naissance jusqu’à 25 ans disent les experts, le cerveau de l’Homme apprend énormément en fonction de son environnement. Peut-être que nous avons aussi une très grande base de faits et de connaissances, que nous savons parfaitement exploiter.

L’IA et la cybersécurité

Beaucoup d’exemples dans les médias montrent la satisfaction que certains ont d’être plus forts que la machine. Mais au-delà de ce fait, on comprend qu’il est impératif de ne délivrer uniquement des IA qui soient inviolables et parfaitement cyber-sécurisées. Aucune déviation ou erreur ne doit être acceptable ; que ce soit au niveau militaire ou au niveau du grand public.

Une IA inviolable serait une machine qui aurait la capacité de prendre conscience que les questions et affirmations échangées ne contournent pas les règles éthiques définies lors de son apprentissage et de résister à une tentative de perversion.

Une IA cyber-sécurisée devrait gérer la notion de confidentialité des informations (via la classification) pour éviter de partager des informations sensibles à partir de question des utilisateurs.

Or ce n’est pas le cas ! En effet, certains utilisateurs trouvent que la synthèse et les informations transmises par ces agents conversationnels et autres solutions génératives de contenus animés par une IA, sont un gain de temps considérable. A ce titre, ils sont de plus en plus utilisés dans le milieu professionnel. Pour le confirmer, un sondage du CESIN (27/03/2023) indique que seulement 25% des membres de l’association ont accompagné la mise à disposition de ChatGPT dans leur entreprise avec des recommandations pour éviter de partager des données sensibles !

Or, en communiquant à ces IA en mode apprentissage, des informations du contexte professionnel qui peuvent être sensibles, ces dernières entrent dans la base de données de ces IA… Elles seront désormais accessibles à tous les utilisateurs ; y compris à d’autres entreprises concurrentes qui sauront lancer des requêtes pour extraire ce type d’informations sensible ; aucune barrière de sécurité ne peut les empêcher ce jour. Attention, aujourd’hui encore, ces agents conversationnels n’ont pas de notions de classification des informations ; les utilisateurs doivent en être bien conscient.

D’autres cas intéressants sont mis en évidence par les premiers testeurs de ChatGPT.

L’IA est aussi utilisée pour générer des images (Deepfake) qui, lorsqu’elles sont conçues de manière appropriée, peuvent porter atteinte à notre jugement. Malheureusement, comme dans le cas de l’utilisation d’une IA pour répondre à un examen, nous devons mieux exercer notre libre arbitre pour identifier ce qui n’est pas issu d’un raisonnement humain ou est contradictoire à un contexte que l’on doit maîtriser ; en attendant une IA pour identifier un message provenant d’une IA ?

L’IA, réalité anxiogène ?

Comment ne pas rester à l’écoute de Stephan Hawkins qui nous alertait en indiquant que l’intelligence artificielle détruira l’Homme, ou encore à cette lettre signée par d’éminents spécialistes en juillet 2015 alertant nos sociétés face à l’utilisation de l’IA dans le monde militaire. En 2015, nous craignions que des robots tueurs animés par des IA soient développés pour tuer des Humains… malgré toutes les volontés souhaitant l’interdiction de ce type de projet. Human Rights Watch défend depuis des années l’interdiction d’armes comme les mines anti-personnelles, les armes à sous-munitions et les robots tueurs d’humains. Si ces derniers n’ont pas encore été identifiés sur le champ de bataille russo-ukrainien, ce n’est malheureusement pas le cas des deux autres armes.

Le risque est présent sachant que seul un nombre restreint de pays (30 et pas les plus importants économiquement parlant…) se sont réellement engagés à les interdire. Cependant, ce type d’assemblée internationale souffre toujours de pouvoirs de décision fondés sur le plus petit dénominateur commun qui peut exercer une minorité de blocage. Face à l’efficacité de ces armes, il y a peu de chance que les grands pays (y compris la France[1]) s’engagent à interdire ces Robots.

Avec les effets glaçants des prédictions des transhumanistes dont Ray Kurzweil nous abreuve, on pourrait croire en une dégénération du cerveau de l’Homme pour qu’il se laisse porter par un monde de robots agissant intelligemment à sa place, nous reléguant à un rôle végétatif.

Hal 9000, dans « 2001 l’Odyssée de l’espace » avait ainsi pris le contrôle de l’être humain et aujourd’hui certains chercheurs imaginent des IA qui s’approprierait l’énergie nécessaire à leur fonctionnement et seraient en capacité de priver les humains de cette ressource essentielle. L’article intitulé « une catastrophe existentielle n’est pas juste probable, elle est possible » atteste cette hypothèse

Un règlement européen sur l’intelligence artificielle

Depuis avril 2021, l’Union Européenne a défini une réglementation visant à protéger les individus et les infrastructures critiques des nations. Cette réglementation encadre l’usage des IA selon les risques : a) inacceptables comme la sécurité, les moyens de subsistance et le droit des personnes et b) les risques élevés touchant les infrastructures critiques, l’éducation, la formation, les services publics ou privés essentiels… L’objectif est d’assurer une transparence de l’information sur l’utilisation d’une IA.

Quels sont les risques de dérives des IA génératives ?

Une absence de Gouvernance

Le premier combat à mener dans l’évolution de l’IA, est déjà d’éviter que des laboratoires ou des individus développent des machines à tuer ou plus généralement des armes qui pourraient servir une domination exercée par une seule personne. Même si on constate que la volonté de dominer ne vient pas de l’IA en tant que tel, c’est bien l’Homme, on le sait, qui pourra utiliser cette solution technique pour être supérieur à ses congénères.

Il est donc fortement souhaitable de mettre en place une gouvernance au niveau international pour que ces IA entraînées par tous les cas d’usages soumis, adoptent une éthique qui serve l’évolution de l’Humanité, tout en respectant notre la planète.

L’impact sur l’évolution humaine et l’économie

Certains robots sont animés par des IA les robots humanoïdes auront certainement un très fort impact sur notre évolution. Ces robots seront de plus en plus intelligents et nous apporteront une qualité de vie incontestable concernant les métiers manuels et administratifs. Leur développement s’inscrit dans une amélioration souhaitée de notre vie. Cela est au risque de la suppression d’un grand nombre de professions qui seront immanquablement remplacées par des machines industrielles et autre assistants administratifs plus intelligents et fiables que les humains. Aujourd’hui, on commence à identifier les métiers administratifs comme étant les plus touchés. A contrario, de nouveaux métiers sont en création comme ceux qui savent exploiter la valeur ajoutée d’une IA.

Comme le décrit Bernard Chaussegros dans une tribune, l’IA prend position dans de nombreux domaines en traitant un grand nombre d’informations pour nous donner des opportunités d’optimiser nos actions et être plus efficace. Il est fort probable que cette révolution de l’IA et des robots aura aussi un impact sur l’âge de la retraite puisqu’une partie de la population sera remplacée par des robots animés par des IA ! Attendons que les politiques s’emparent du sujet et ajoutent des taxes aux entreprises qui indirectement proposeront de remplacer des humains par des machines robotiques et des automates ; ces taxes permettront-elles de payer des personnes à ne pas travailler ?

L’IA freine-t-elle la liberté ?

Au-delà de l’idée de la pensée unique et comme le dit Peter Thiel repris par Gaspard Koenig, l’IA est « communiste ». Les exemples sont nombreux comme l’assistance de l’IA pour automatiser des données relevées par les caméras de vidéosurveillance en Chine ou au Emirats Arabes Unis, ou encore le fonctionnement du GPS qui vous indique le meilleur chemin pour ne pas saturer les autres chemins ; mais qui n’est pas forcément le trajet le plus optimisé pour soi-même. On voit que souvent, l’IA procède pour le bien commun de tous ; c’est sans doute d’ailleurs dans cet objectif que les règles de ce type de moteur d’inférence sont définies. Le risque revient alors dans le choix « politique » qui sera défini dans les règles du moteur d’inférence. Il ne faut pas que ce soit une seule personne qui puisse prendre ce type de décision mais bien un conseil d’orientation animé par une gouvernance.

Dans ce cadre, faut-il une IA supervisée, hyper-réglementée ou au contraire, une grande liberté pour que toutes les idées soient développées pour le bien de tous ?

De même, on comprend que si notre cerveau n’était pas entraîné et libre, nous n’aurions pas pu bénéficier des génies de notre Histoire, comme Léonard de Vinci, qui ont guidé des siècles plus tard les laboratoires de recherches et le développement de l’Homme, en apportant une vision.

Cette évolution préfigure-t-elle l’utilisation des robots à la place de l’Homme ? Quelle sera donc l’évolution de l’Humain s’il n’entretient pas son intelligence et sa capacité créative en se complaisant dans une oisiveté absolue ? Nous n’en sommes pas encore tout à fait là, mais la question se pose.

Il reste encore beaucoup de travaux de recherche à mener…

Aujourd’hui, l’enjeu pour les IA, et en particulier les IA génératives, est de prédire justement et sans doute « mieux » que l’Homme. Elles s’appuient donc sur un grand nombre d’informations pour statistiquement proposer une bonne réponse. Au fil des itérations, les poids statistiques et les biais sont affinés en fonction du résultat attendu pour donner des valeurs de plus en plus précises. Il reste encore cependant de nombreux progrès à faire.

Au niveau des images, de nombreux assistants proposent de supprimer le flou d’une photo et même si ChatGPT-4 apporte beaucoup d’amélioration dans la prédiction d’images, cela se révèle beaucoup plus difficile lorsqu’il s’agit de supprimer des images d’un dessin animé ou encore demander à une IA de finir un film. En effet, les images sont découpées par tokenisation sous forme de vecteurs mais, reconstituer une image sur la base d’un scénario est l’objet d’intenses recherches actuellement.

Et puis, au-delà de la difficulté de transmettre des émotions dans un texte, la beauté des images est aussi un enjeu fort de progrès sur lequel les chercheurs comme Yann Le Cun, partagent leurs travaux ouvertement.

Les atouts de l’intelligence humaine

Les premières IA utilisaient un moteur d’inférences basés avant tout sur un grand nombre de données, plutôt qu’un moteur d’inférence « puissant ». Depuis quelques mois, avec l’apprentissage, les IA commencent tout juste à rivaliser l’intelligence humaine ; qui sait, pour sa part construire un raisonnement sur la base d’un faible nombre de faits. En fait, l’intelligence humaine possède peu de faits (base de données) mais une bonne grammaire (base de règles) ; et c’est une de ses forces.

Cette Intelligence Humaine est aussi très peu consommatrice des ressources de notre planète, par rapport à l’IA qui a besoin de beaucoup d’énergie (on parle là d’un rapport de 1 à 1000) pour fonctionner. C’est donc notre intelligence, beaucoup plus « frugale », qu’il faut privilégier. Quitte à humblement demander parfois un conseil à une IA pour bénéficier de la puissance de la machine, tout en restant maître de son destin.

Pour en revenir à l’un de mes sujets fétiches, la cybersécurité, l’IA est ainsi parfaite pour identifier les attaques de type fraude au président (BEC)[2] et identifier des comportements anormaux issus d’une usurpation de son identité par exemple. Sa capacité d’analyse des faits donne, avec un bon taux de fiabilité, la confirmation d’une tentative de fraude. Mais les hackers vont développer des attaques qui identifieront les IA et apprendront à la contourner. Eux-aussi sont amenés à utiliser un mélange d’intelligence humaine et artificielle.

Au final, ce tour d’horizon contribue à nous montrer que si l’IA a sans conteste un apport vraiment bénéfique pour l’Humanité et notre société (car elle permet une très bonne approche générique de la ou des solutions à des problèmes, y compris complexes), il est en revanche urgent et impératif d’établir une gouvernance. Cette dernière est essentielle pour que ces machines contribuent à des objectifs plus éthiques et responsables afin de maintenir nos libertés et nos démocraties.

[1] Même si notre pays a indiqué qu’elle ne concevrait pas ce type d’armes

[2] Des solutions efficaces existent déjà comme https://tehtris.com/fr/ ou https://www.proofpoint.com/fr

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders Alliancy Elevate

Alliancy Elevate International

International Nominations

Nominations Politique publique

Politique publique