Mistral AI, LightOn, Poolside, Hugging Face… Plusieurs startups de l’intelligence artificielle, françaises ou implantées dans l’Hexagone, peuvent constituer des alternatives ou compléments aux champions américains. Mais qui sortira gagnant sur un marché en pleine expansion ?

La France et l’Europe peuvent-elles offrir une alternative à la monomanie OpenAI ? Une telle option Made in France (ou plutôt « Coded in France ») reste à développer. Comme le soulignait la directrice générale de France Digitale Maya Noël lors de Big Data & AI Paris, le Vieux Continent est toujours en quête de champions et de géants de l’IA générative. Et ce bilan est “dommageable”.

La France et l’Europe peuvent-elles offrir une alternative à la monomanie OpenAI ? Une telle option Made in France (ou plutôt « Coded in France ») reste à développer. Comme le soulignait la directrice générale de France Digitale Maya Noël lors de Big Data & AI Paris, le Vieux Continent est toujours en quête de champions et de géants de l’IA générative. Et ce bilan est “dommageable”.

Pour autant, l’Europe – et surtout la France – ne reste pas inactive. Elle “fait des paris”, notamment en investissant 105 millions d’euros dans Mistral AI. “C’est un énorme pari”, réagissait Maya Noël fin septembre. La réponse européenne pourrait s’avérer trop tardive face aux mastodontes et leurs milliards que sont OpenAI/Microsoft, Google Bard et AWS/Anthropic – pour ne citer qu’eux.

Mistral AI : l’énorme pari

Opposée à la concurrence américaine, l’Hexagone dispose donc aujourd’hui de deux options principales sur le volet des LLM et de leur spécialisation : LightOn et Mistral AI (sans compter une multitude de startups spécialisées sur des verticales : RH, chatbot e-commerce, etc.). La seconde a été fondée en 2023 par trois chercheurs en provenance des Gafam : Timothée Lacroix, Guillaume Lample et Arthur Mensch.

Les deux premiers ont travaillé à la conception du modèle open source LLaMA de Meta. Quant au dernier membre, il arrive tout droit de Google DeepMind. Grâce à leurs CV et à leurs promesses, les fondateurs ont donc levé 105 millions d’euros en amorçage – et cela, sans même disposer alors d’un produit.

Depuis, les experts en IA français ont finalisé leur premier modèle open source. Mistral 7B, c’est donc un modèle de petite taille sous licence Apache 2.0 avec 7 milliards de paramètres, mais qui “surpasse de loin les performances du meilleur modèle de 13 milliards de paramètres disponible à ce jour”.

Ce premier produit de la startup était très attendu. Il doit faire la démonstration du savoir-faire de ses développeurs, mais aussi rassurer le marché quant à la capacité de Mistral à délivrer des solutions rapidement exploitables en production.

Mistral 7B, c’est pour ses créateurs un produit qui “permet d’ores et déjà à ses utilisateurs de résoudre un grand nombre de tâches de traitement ou de génération de texte.” Accompagné d’une solution de déploiement efficace sur “tous les environnements cloud existants”, le modèle promet en outre “une grande facilité d’utilisation.”

Mais comment une jeune pousse de quelques mois pourrait-elle rivaliser avec OpenAI, ses modèles gigantesques, et Microsoft, son partenaire international implanté dans presque toutes les organisations ? Par la différenciation. Arthur Mensch, son CEO, veut se démarquer avec des modèles plus petits, spécialisés, ouverts et moins coûteux à exploiter. Ulrich Tan, qui dirige le Datalab de la direction interministérielle du numérique juge ainsi le premier aperçu « très intéressant et léger », alors que la Dinum cherche à bâtir son propre modèle souverain et open source.

La riposte des petits modèles spécialisés et ouverts

La proposition de valeur, c’est ainsi de rompre avec l’offre de type boîte noire portée par OpenAI. Avec son premier modèle, Mistral 7B, le Français promeut donc une IA générative “sous le contrôle complet de l’utilisateur, qui maîtrise entièrement ses flux de données.”

“Ce qui n’est pas désirable, c’est que deux ou trois acteurs américains monopolisent la discussion, décident des biais, de l’orientation culturelle des modèles qu’on déploie. L’angle open source que nous avons retenu fait partie de notre stratégie éthique visant à démocratiser ces technologies de manière responsable”, déclarait en juin Arthur Mensch lors de la conférence IMAgine Day IA Gen.

Hanan Ouazan, Partner & Lead Generative AI pour Artefact, voit dans Mistral AI “un super projet” et un casting de rêve de chercheurs qui avancent très vite. “Courant octobre, ils sortiront un deuxième modèle plus grand”, l’illustre-t-il. “C’est une entreprise qui va vite et qui, à mon sens, est sur les bons sujets.”

Artefact collabore avec la startup sur de premiers PoC auprès de certains de ses clients. Son offre, résume l’expert, se compose globalement de LLM fondation, de modèles fine-tunés, et d’outils de mise à disposition. Pour Hanan Ouazan, la valeur ajoutée de Mistral AI repose sur le manque qu’elle comble sur le marché en matière de transparence des modèles et de propriété intellectuelle autour de leur entraînement.

“En tant qu’acteur français et de l’open source, ils ont aussi cette capacité à assurer que les modèles pourront tourner sur des infrastructures en Europe. Et ce n’est pas un point auquel peuvent répondre tous les offreurs du marché”, souligne-t-il encore. Les fournisseurs cloud devraient quant à eux s’aligner sur les prochains mois.

Le spécialiste de l’IA Gen met aussi en avant la stratégie de Mistral consistant à proposer des modèles plus petits et très spécialisés, en rupture avec la tendance sur le marché. Hanan Ouazan salue une “démarche intéressante”, plus en adéquation avec les attentes des utilisateurs et consommateurs, notamment en termes d’impacts (coûts et environnementaux) des modèles.

LightOn : une expertise très établie

Une autre entreprise a précédé Mistral AI avec un positionnement très comparable : LightOn. Artefact ne se prête pas au jeu d’une comparaison de leurs performances réciproques, qui doivent de toute façon s’apprécier par cas d’usage. La startup la plus ancienne se distingue cependant en proposant un front sous forme d’un logiciel, là où Mistral privilégie API et modèles.

Une autre entreprise a précédé Mistral AI avec un positionnement très comparable : LightOn. Artefact ne se prête pas au jeu d’une comparaison de leurs performances réciproques, qui doivent de toute façon s’apprécier par cas d’usage. La startup la plus ancienne se distingue cependant en proposant un front sous forme d’un logiciel, là où Mistral privilégie API et modèles.

Hanan Ouazan insiste sur “l’expertise très établie” dont dispose LightOn et sur la compétence de ses fondateurs. Les deux acteurs français restent cependant “assez concurrents”, considère-t-il avec “des modèles qui ont pour but de répondre aux mêmes enjeux de propriété intellectuelle des entreprises et de souveraineté, tout en apportant des solutions opérationnelles et offrant des bons niveaux de performance.”

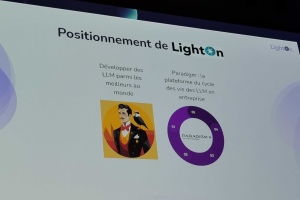

Offre, positionnement, cas d’usage couverts… Laurent Daudet, directeur général et co-fondateur de LightOn (aux côtés d’Igor Carron) les détaillait lors du salon Big Data 2023. “Le gros cas d’usage qui arrive, c’est véritablement le Q&A sur les corpus documentaires. Cela nous est souvent demandé”, témoignait-il par exemple.

Laurent Daudet anticipe un “avant et un après” en matière de relation client avec des recommandations et des communications plus personnalisées. Cette personnalisation, en fonction notamment de données utilisateur, pourra descendre jusqu’au niveau des fiches produit, estime-t-il. “Générer des fiches à la volée, c’est une tâche que les LLM font très bien”.

Pour satisfaire les besoins internes en matière d’amélioration de la productivité, LightOn se positionne donc comme fournisseur de solution avec une approche en mode Question & Réponse, en langage naturel, pour interroger des bases documentaires propres aux entreprises utilisatrices.

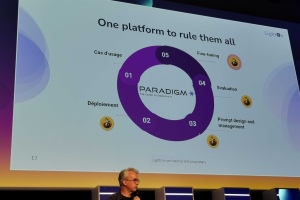

Afin de répondre aux différents besoins, LightOn fournit une plateforme baptisée Paradigm permettant de traiter les étapes du workflow de l’IA générative : cas d’usage, déploiement, prompt design et management, évaluation et fine-tuning.

“Paradigm permet de gérer tout le cycle de vie des LLM dans l’entreprise (…) et nous utilisons l’IA à chacune de ces étapes”, explique Laurent Daudet. L’IA pourra ainsi être mobilisée afin de définir les bons prompts, c’est-à-dire les plus performants, et cela sans devoir recourir aux services d’un prompt engineer.

Paradigm : la plateforme et l’approche intermédiaire

“Notre objectif est de continuer à développer des LLM parmi les meilleurs au monde”, revendique le dirigeant, qui cite notamment la création d’un modèle de 180 milliards de paramètres. Il souligne aussi l’expertise en matière d’entraînement et de fine-tuning, parfois sur plusieurs mois avec plus de 3000 GPU exploités.

“Notre objectif est de continuer à développer des LLM parmi les meilleurs au monde”, revendique le dirigeant, qui cite notamment la création d’un modèle de 180 milliards de paramètres. Il souligne aussi l’expertise en matière d’entraînement et de fine-tuning, parfois sur plusieurs mois avec plus de 3000 GPU exploités.

“Nous savons le faire. On sait aussi faire des LLM plus petits capables de passer en production facilement, sur des corpus particuliers, par exemple une langue définie”, indique encore le directeur général de LightOn. Selon lui, la valeur repose dans le développement des modèles et dans la fourniture des outils (ici Paradigm) permettant leur adoption et leur adaptation “en production à des cas d’usage réels”.

LightOn se veut une solution intermédiaire entre le tout propriétaire et le tout open source. “Concentrez-vous sur votre cœur de métier. Si vous êtes data scientist, ce n’est pas forcément de gérer le MLOps pour le déploiement des modèles mais de les amener auprès des métiers. Nous apportons pour cela des briques technologiques prêtes à l’emploi.”

Hugging Face, Poolside AI… Des généralistes et des spécialistes

Mistral AI et LightOn peuvent être considérés comme des généralistes de l’IA générative, mais fournissant des modèles destinés à être spécialisés. D’autres acteurs du marché se spécialisent sur des cas d’usage donnés comme iAdvize avec l’e-commerce et la relation client.

Ces prestataires ne développent pas nécessairement leurs modèles. Ils vont plus souvent customiser des technologies existantes, propriétaires ou open source. iAdvize, qui compte CDiscount comme client, a développé deux copilotes, des systèmes d’IA destinés aux conseillers et aux cyber-acheteurs. L’entreprise exploite à cette fin plusieurs LLMs, et en particulier Azure OpenAI en Europe. L’intégration de modèles open source (non précisés) est en cours d’expérimentation.

Poolside a aussi opté pour la spécialisation en se concentrant sur la génération de code informatique, un des cas d’usage majeurs de l’IA générative. Fondée aux Etats-Unis, la startup à laquelle participe l’ex-CTO de Github, se relocalise à Paris. En août, elle a levé 126 millions de dollars.

Poolside partage des points communs avec Mistral AI, dont la domiciliation en France de ses investisseurs, parmi lesquels : Xavier Niel, Rodolphe Saadé, Motier Ventures, encore Bpifrance. Avec ces capitaux, la startup prévoit de recruter et de payer des ressources GPU pour l’entraînement de son modèle.

Autre acteur à suivre : Hugging Face se partage aussi entre les États-Unis et la France. L’entreprise a déjà levé 395 millions de dollars depuis sa création. Une grande partie des salariés est basée en France et sa direction veut doubler l’effectif français. Pour Hanan Ouazan, Hugging Face est à distinguer de LightOn et Mistral puisqu’elle propose avant tout un portail référençant des modèles d’IA disponibles.

“C’est plus un Uber des modèles qu’un restaurant”, résume-t-il, même s’il ajoute que la startup a développé elle-même des modèles. Mise à disposition, documentation et comparaison des modèles constituent son cœur d’activité, plus que la conception proprement dite, centrale chez les deux Français des LLM.

IA Gen : l’Europe a-t-elle déjà perdu la bataille ?

IA Gen : l’Europe a-t-elle déjà perdu la bataille ?

Pour Laurent Daudet de LightOn, trois approches de l’IA Gen sont aujourd’hui possibles (mais non exclusives) : propriétaire, open source et intermédiaire. A chacune des avantages et des inconvénients. L’open source nécessite par exemple des compétences internes, quand le modèle propriétaire crée le risque d’une dépendance technologique.

Mais les alternatives européennes peuvent-elles trouver leur place dans les organisations ? Pour l’expert d’Artefact, elles sont totalement pertinentes, et ne se heurtent pas frontalement à l’offre des hyperscalers.

“Demain, les modèles de Mistral et LightOn seront disponibles dans les registres de modèles de Google, AWS et Microsoft (…) Les modèles vont de plus en plus se spécialiser. Il est donc dans leur intérêt d’offrir une palette d’outils. Je pense que ces géants sont plus intéressés par la fourniture de services connexes à l’IA générative, les ressources cloud en particulier.”

Les hyperscalers, qui ont largement adopté l’open source dans d’autres secteurs (bases de données, conteneurisation….), ne devraient donc pas faire barrage au “raz-de-marée” en cours dans le domaine de l’IA générative, suggère Hanan Ouazan.

“Le marché est tellement grand qu’il y a de la place pour tous”, poursuit-il. “Quant à savoir qui sera encore là dans 1, 2 ou 3 ans, ce sera un acteur qui aura su démontrer que sa solution peut être mise en production. Aujourd’hui, à de rares exceptions, je n’ai pas connaissance d’entreprises ayant réussi la mise en production à l’échelle de modèles d’IA générative.”

Ce bilan tient selon lui à des craintes vis-à-vis des modèles et de leur évaluation pour les adapter et les corriger rapidement sur des axes de performance et de confiance. L’enjeu des prochains mois sera celui de l’industrialisation de l’IA générative, “plus complexe encore que pour le machine learning (…) Les challenges qui attendent les entreprises sont importants et il ne faut pas sous-estimer la complexité de mise en production”, prévient-il.

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders Alliancy Elevate

Alliancy Elevate International

International Nominations

Nominations Politique publique

Politique publique