Révolution informatique, révolution du management, révolution industrielle… les big data, ou le traitement de données à très grande échelle, suscitent un immense enthousiasme. Quelles sont les promesses de cette technologie ?

Révolution informatique, révolution du management, révolution industrielle… les big data, ou le traitement de données à très grande échelle, suscitent un immense enthousiasme. Quelles sont les promesses de cette technologie ?

Ils sautent comme des cabris en criant « big data, big data ! » C’est le nouvel eldorado informatique. Le World Economic Forum les a placées au premier rang des technologies émergentes les plus importantes. Des cabinets d’études affirment que le marché des big data est « si considérable qu’on ne peut même pas l’estimer ». La société d’études américaine IDC s’y risque toutefois. Elle publie une prévision de croissance de plus de 30 % par an d’ici à 2016, sur un marché qui devrait atteindre alors les 23,8 milliards de dollars. Les industriels comme IBM et consorts, mais aussi General Electric, investissent lourdement en R&D. Les start-up, aux Etats-Unis comme en France, pullulent… Les uns y voient une « révolution informatique », d’autres une « révolution du management », et d’autres enfin, une « révolution industrielle ».

Fleur Pellerin, la ministre déléguée chargée des PME, de l’Innovation et de l’Economie numérique, a souhaité, mi-janvier, « une réflexion sur la création d’une filière structurée sur les big data en Ile-de-France, capable d’attirer les investissements étrangers », tout en chargeant l’Afdel (Association française des éditeurs de logiciels et solutions Internet) de cette mission. Ce n’est rien de dire que le sujet est brûlant.

Traiter une avalanche de données

Pourquoi cet engouement ? La raison profonde en est la technologie qui transforme un processus lourd, difficile et coûteux – le traitement de données – en activité (relativement) aisée et très peu chère. Et ce glissement du « rare et cher » à l’« abondant et “gratuit” » est toujours porteur d’une révolution. Songez à l’impact du microprocesseur qui a fait de la puissance de calcul une commodité. Ou à celui de la fibre optique qui a quasiment réduit à zéro le coût de la transmission d’information. Ce qu’on appelle aujourd’hui « big data » possède le même potentiel de transformation. Les portes d’un univers encore largement inimaginable s’entrouvrent. Et le peu qu’on en aperçoit fait déjà rêver (ou frémir, selon le cas…).

Big data, c’est le nom des technologies permettant d’exploiter et de donner un sens pertinent à de fantastiques masses de données, celles disponibles sur Internet notamment. Hier, on appelait cela « data mining ». Le nom a changé car le type et les volumes sur lesquels travaillent les aficionados des big data, ainsi que le traitement en temps réel, n’ont plus rien de commun et exigent des technologies différentes. Le data mining d’hier travaillait sur un nombre assez restreint de données dites « structurées », celles disponibles dans des bases de type SQL. Les big data s’attaquent à tous les types de données, à toutes celles notamment qui s’accumulent sur Internet, sur les réseaux sociaux, mais aussi celles des GPS, des téléphones mobiles… Les données structurées étaient relativement rares. Désormais c’est un déluge permanent. Plus de 1 zettaoctet (1021 octets, soit mille milliards de milliards d’octets) est déversé par an sur Internet !

Et ce n’est encore rien comparé à ce qui se prépare. Plusieurs évolutions concourent à faire des big data, une réalité. La première, on l’a vu, est la disponibilité d’une masse considérable d’informations de tout poil à traiter. Un filon inépuisable. La deuxième est l’arrivée de capteurs à faible coût qui vont rendre possible la saisie d’informations n’importe où, fournissant ainsi des quantités colossales de nouvelles données à exploiter. Troisième évolution, la formidable capacité de traitement qu’offre aujourd’hui le moindre micro-ordinateur.

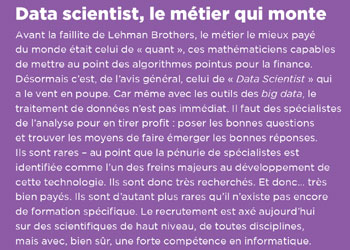

Cela ne serait rien sans la grande innovation : l’arrivée des technologies qui rendent possible le traitement de masses d’information colossales à faible coût. Elles sont le fruit de start-up, californiennes le plus souvent, qui offrent des outils comme Hadoop ou Map Reduce, de nouveaux types de base de données dites NoSQL… Ces outils permettent de maîtriser des quantités énormes d’informations comme si de rien n’était. Ils autorisent, même sur un banal PC, des traitements qu’on n’aurait pas imaginé il y a quelques années et qui permettent d’extraire des informations significatives d’un magma a priori incohérent (à condition toutefois de disposer d’un professionnel, voir encadré ci-contre). Mieux encore : comme le souligne Ted Dunning, spécialiste américain du sujet, auparavant, on arrivait rapidement à un point d’équilibre où le coût marginal de traitement d’un plus gros volume de données dépassait le bénéfice marginal issu de ce traitement. Aujourd’hui, en traiter dix fois plus coûte beaucoup moins cher que le gain obtenu. Bref, hier on y réfléchissait à deux fois avant de se lancer dans l’analyse de données. Désormais puisque ça ne coûte « rien », no limit ! Tout devient possible.

La business intelligence

Tout ! mais quoi précisément ? Il y a d’abord ce qui est toujours mis en avant, la tarte à la crème des big data : les applications pub et marketing. Typiquement ce que font les Amazon, Facebook et autres Google en exploitant les flots de data dont ils disposent. Par exemple, pour recommander un produit en fonction des habitudes d’achat, cibler et personnaliser la publicité… Cet aspect marketing est, à l’évidence, le plus en vue aujourd’hui et a vocation à se généraliser. Mais ce n’est en réalité que la partie émergée de l’iceberg.

L’autre application majeure des big data est la businessintelligence, l’exploitation des données pour l’aide à la décision dans les entreprises. Dans un récent article de la Harvard Business Review, Andrew McAfee et Erik Brynjolfsson, deux spécialistes réputés des technologies de l’information du MIT, n’hésitent pas à parler d’une « révolutiondu management ». Une révolution car, selon eux, s’ouvre désormais la possibilité de prendre un grand nombre de décisions en s’appuyant sur des résultats concrets issus du traitement des données. Fini le temps de « l’intuition ». Finie l’époque où les décisions du plus haut placé dans l’entreprise étaient parole d’évangile. Désormais ce seront les données qui trancheront et cela aura un profond impact sur le rôle des managers.

Il y a peut-être plus important encore : l’impact de cette technologie pour l’industrie. Ici, c’est General Electric qui lance le concept. L’entreprise a appelé« Internet Industriel » le traitement, grâce aux technologies des big data, des informations issues de produits industriels bardés de capteurs. Pour le géant américain, ce n’est pas moins que la « troisièmerévolution industrielle » qui se profile… Excusez du peu ! (lire encadré « La troisième révolution industrielle » en bas de page). Il n’est d’ailleurs pas difficile dans cette optique (saisie d’informations par des capteurs, traitement grâce aux big data) d’élargir la vision. A l’extrême limite, on découvre ainsi l’immense projet de recherche Cense mené par HP avec Shell. Cense pour Central Nervous System for the Earth, vise à mettre l’environnement sous surveillance en disséminant des milliards de nanocapteurs dans le sol, les fonds marins, sur les sites sensibles ou sur le vivant pour en recueillir, en temps réel, toutes les données possibles. Ce vaste « monitoring » de la planète ne sera possible que si des capteurs ad hoc sont mis au point à très faible coût. HP s’y emploie. Mais, au bout du compte, ce sont les capacités de traitement de type big data qui rendent un tel projet envisageable.

Vers de nouvelles applications

Enfin, il y a une réalité difficile à cerner, mais qu’on peut néanmoins pressentir, comme le fait Henri Verdier. Il est responsable d’Etalab – mais surtout spécialiste des big data et fondateur d’une start-up du domaine (MFG Labs). Il ne doute pas que le phénomène va engendrer une multitude de start-up qui inventeront mille et une façons d’exploiter des données de toutes sortes, conduisant à autant d’applications encore inimaginables. Déjà une jeune entreprise israélienne, Waze, exploite les informations issues des GPS des téléphones portables des automobilistes pour détecter et avertir des embouteillages sur les routes américaines, proposant en temps réel le parcours le plus rapide.

On peut rejoindre Henri Verdier et parier que bien d’autres trouveront le moyen de tirer parti de la quasi-infinité de données potentiellement disponibles. Ce n’est qu’une question d’imagination. Et les adeptes du numérique ont plus souvent qu’à leur tour prouvé qu’ils n’en manquent pas.

Dans un avenir proche, il est assez facile de deviner ce qui va se passer. Actuellement, l’excitation sur le sujet est à son comble. Très vite, le choc avec la réalité (les problèmes comme la sécurité ou la confidentialité, par exemple) amènera son lot de désillusions et de déceptions. Très vite, des doutes s’exprimeront.

Des promesses ne seront pas tenues, quand d’autres verront le jour. C’est le sort de toute technologie émergente : elle doit vivre sa vie et trouver sa juste place. Elle est difficile à déterminer précisément à l’avance. Mais on peut avancer, sans grand risque de se tromper, que ce traitement des données à très grande échelle est appelé à jouer un rôle considérable. Rendez-vous dans cinq ou dix ans…

—

La ville de New York vient d’accorder une subvention de 15 millions de dollars à l’université Columbia (photo), pour l’Institute for Data Science and Engineering (idse.columbia.edu), afin d’approfondir l’analyse des big data. Ses domaines de recherche : les villes intelligentes, les nouveaux médias, le traitement analytique médical, le traitement analytique financier et la cybersécurité. Objectif : booster l’économie de la ville…

—

La « troisième révolution industrielle », selon General Electric

La « troisième révolution industrielle », selon General Electric

Un centre de R&D flambant neuf hébergeant 400 chercheurs. Un investissement de 1,5 milliard de dollars sur trois ans. Avec cela, General Electric (GE) pense être aux premières loges de la troisième révolution industrielle qu’il a appelée « Industrial Internet »*. Il s’agit de barder ses produits – moteurs d’avions, turbines, locomotives, machines d’IRM… – de capteurs qui fourniront, en temps réel, une avalanche de données sur leur fonctionnement.

Analysées grâce aux techniques des big data, elles permettront de prendre des décisions propres à rendre les produits plus efficaces (prévenir les pannes, optimiser la maintenance, économiser l’énergie…). Et pas seulement les produits individuels, mais également l’ensemble du système dans lequel ils sont insérés (une usine, une flotte d’avions, un aéroport…). Pour situer les volumes en jeu, GE indique qu’il y a, grosso modo, 43 000 réacteurs d’avions en activité et qu’au moins trois grandes pièces tournantes peuvent être instrumentées pour suivre le moteur en temps réel. Ces moteurs auraient ainsi le potentiel de produire en un an « davantage de données que celles collectées par GE depuis qu’il est dans le métier de l’aviation », souligne l’industriel. Il estime en outre qu’il y a au moins « trois millions de “choses qui tournent” qui pourraient être instrumentées de la sorte ».

* Lire le rapport: « Industrial Internet : Pushing the Boundaries of Minds and Machines » de Peter C. Evans et Marco Annunziata sur : www.gereports.com/meeting-of-minds-and-machines

Pour aller plus loin, découvrez notre Centre de Ressources big data.

International

International Nominations

Nominations Politique publique

Politique publique